Un grupo de expertos opina sobre si los programas responsables de IA (RAI) gobiernan eficazmente las soluciones de IA generativa como ChatGPT.

Por segundo año consecutivo, MIT Sloan Management Review y Boston Consulting Group (BCG) han reunido a un grupo internacional de expertos en IA. Mismo que está formado por académicos y profesionales, para que nos ayuden a comprender cómo se está aplicando la inteligencia artificial responsable (RAI) en las organizaciones de todo el mundo.

Este año, estamos examinando en qué medida las organizaciones están abordando los riesgos derivados del uso de herramientas de IA desarrolladas interna y externamente.

¿Cómo controlar la IA? Los programas de Inteligencia Artificial Responsable son la solución

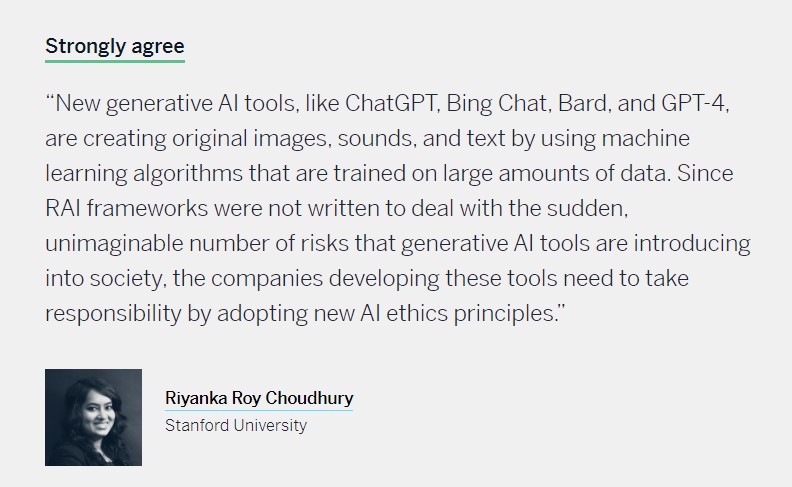

La primera pregunta que planteamos a nuestros panelistas fue sobre las herramientas de IA de terceros. Este mes, profundizamos en los riesgos específicos asociados a la IA generativa. Un conjunto de algoritmos que pueden utilizar datos de entrenamiento no verificados para generar contenidos como texto, imágenes o audio. Estos pueden parecer realistas o factuales, pero pueden también ser tendenciosos, inexactos o ficticios.

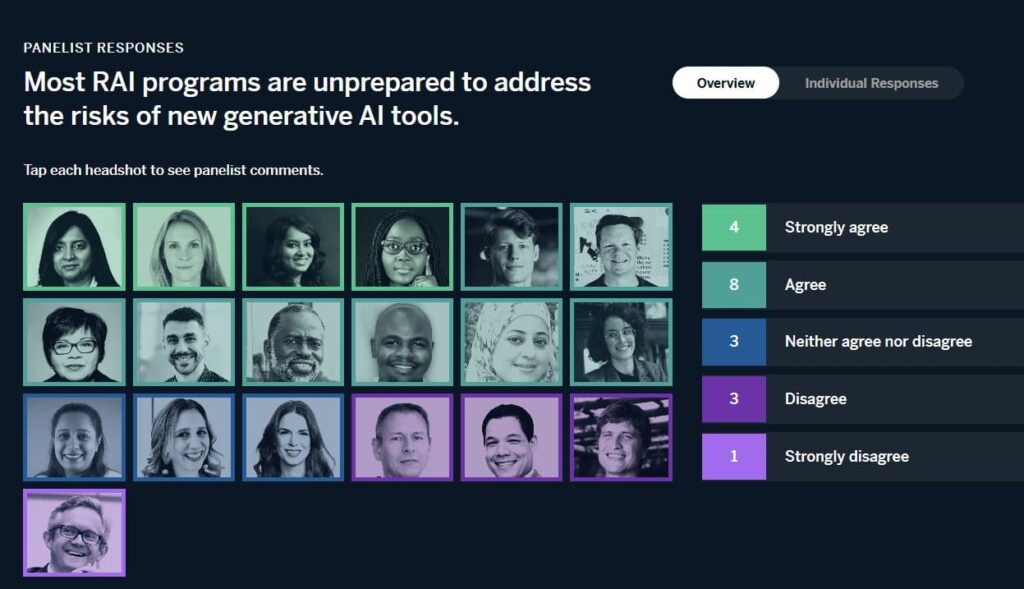

El 63 por ciento de nuestros panelistas está de acuerdo o muy de acuerdo con la siguiente afirmación:

La mayoría de los programas de RAI no están preparados para abordar los riesgos de las nuevas herramientas de IA generativa.

Es decir, los programas de RAI están claramente luchando para abordar las posibles consecuencias negativas del uso de la IA generativa. Sin embargo, muchos de nuestros expertos afirmaron que un enfoque que haga hincapié en los principios básicos de RAI integrados en el ADN de una organización, junto con un programa de RAI que se adapte para abordar riesgos nuevos y en evolución, puede ayudar.

Basándonos en las opiniones de nuestros panelistas, ofrecemos algunas recomendaciones sobre cómo las organizaciones pueden empezar a abordar los riesgos de la IA generativa.

Cómo crear resiliencia cibernética antes de que ocurra el próximo ataque

Afrontar los riesgos en la práctica

Según nuestros expertos, los programas de RAI tienen dificultades para abordar los riesgos asociados a la IA generativa. Eso por al menos tres razones. En primer lugar, las herramientas de IA generativa son cualitativamente diferentes de otras herramientas de IA.

Jaya Kolhatkar, director de datos de Hulu y vicepresidente ejecutivo de datos de Disney Streaming, observa que los desarrollos recientes:

“Muestran algunas de las herramientas de IA de propósito más general que puede que no hayamos considerado como parte de una iniciativa de IA responsable”.

Dada la naturaleza de propósito general de la tecnología, añade Richard Benjamins, estratega jefe de IA y datos de Telefónica:

“Un programa de RAI que evalúe el algoritmo de IA sin un caso de uso específico en mente no es apropiado para la IA generativa. Eso debido a que el impacto ético y social dependerá del caso de uso específico.”

Totalmente de acuerdo

“La mayoría de los programas de RAI abordan los riesgos de los sistemas de IA tradicionales. Estos se centran en detectar patrones, tomar decisiones, perfeccionar análisis, clasificar datos y detectar fraudes. Por otro lado, la IA generativa utiliza el aprendizaje automático para procesar una gran cantidad de datos visuales o textuales. Luego determina qué cosas tienen más probabilidades de aparecer cerca de otras cosas. Debido a la naturaleza de los conjuntos de datos utilizados en las herramientas de IA generativa y a los posibles sesgos, la mayoría de los programas de RAI no están preparados para hacer frente a los riesgos de las nuevas herramientas de IA generativa.”

La inteligencia artificial responsable permite el tipo de innovación que importa

La evolución de la RAI

Al igual que la IA avanza a un ritmo sin precedentes, los programas de RAI deben evolucionar continuamente.

Giuseppe Manai, cofundador, director de operaciones y científico jefe de Stemly, advierte:

“Las herramientas generativas evolucionan rápidamente y no se conoce del todo el alcance de sus capacidades, presentes y futuras”.

Por esa razón, Mudongo aconseja a las organizaciones que evolucionen continuamente sus programas:

“Al igual que con cualquier herramienta de IA, es crucial evaluar y supervisar a fondo los riesgos asociados con las herramientas de IA generativa y adaptar los programas de RAI en consecuencia. A medida que las nuevas tecnologías de IA continúan surgiendo y evolucionando, es importante que los programas de RAI se mantengan actualizados y gestionen proactivamente los riesgos para garantizar un uso responsable de la IA.”

La IA produce continuamente nuevos riesgos, por eso existe la RAI

En segundo lugar, y relacionado con su naturaleza cualitativamente diferente, la IA generativa introduce nuevos riesgos. Como explica Oarabile Mudongo, especialista en políticas del Observatorio Africano de IA Responsable, dice:

“Los riesgos asociados a las herramientas de IA generativa pueden diferir de los asociados a otras herramientas de IA, como los modelos de aprendizaje automático preconstruidos o las herramientas de análisis de datos. Los programas de IA que no han abordado específicamente estos riesgos pueden no estar preparados para mitigarlos”.

¿Qué es la Inteligencia Artificial y por qué todo mundo habla de ella?

Del mismo modo, la jefa de ética y uso humano de Salesforce, Paula Goldman, argumenta:

“La IA generativa introduce nuevos riesgos con mayores apuestas en el contexto de un negocio global. Lo que hace que esta tecnología sea tan singular es que estamos pasando de la clasificación y predicción de datos a la creación de contenidos. A menudo utilizando grandes cantidades de datos para entrenar modelos fundacionales.”

Esto no es algo que los programas de la RAI estén necesariamente equipados para abordar.

En tercer lugar, los avances en IA generativa están superando la maduración de los programas de RAI. Por ejemplo, Philip Dawson, responsable de política de IA en Armilla AI, sostiene:

“Los programas de RAI que exigen la implantación de marcos de gestión de riesgos de IA están bien posicionados para ayudar a las empresas a gestionar los riesgos asociados a las nuevas herramientas de IA generativa desde el punto de vista de los procesos”.

Pero advierte:

“La mayoría de las empresas aún tienen que adaptar sus programas de gestión de riesgos de terceros al contexto de la IA y no someten a los proveedores de IA o sus productos a evaluaciones de riesgos. En consecuencia, las empresas son en gran medida ciegas a los riesgos que están asumiendo cuando adquieren aplicaciones de IA de terceros.”

Del mismo modo, el líder responsable de IA de Dataiku, Triveni Gandhi, dice:

“A medida que aumenta el ritmo de desarrollo no regulado, los programas de RAI existentes pueden no estar preparados en términos de las herramientas especializadas necesarias para comprender y mitigar el daño potencial de las nuevas herramientas.”

¿La Inteligencia Artificial cambiará por completo el Internet?

La evolución de la RAI

Al igual que la IA avanza a un ritmo sin precedentes, los programas de RAI deben evolucionar continuamente para hacer frente a riesgos nuevos.

Giuseppe Manai, cofundador, director de operaciones y científico jefe de Stemly, advierte:

“Las herramientas generativas evolucionan rápidamente y no se conoce del todo el alcance de sus capacidades, presentes y futuras”.

Por esa razón, Mudongo aconseja a las organizaciones que evolucionen continuamente sus programas:

“Al igual que con cualquier herramienta de IA, es crucial evaluar y supervisar a fondo los riesgos asociados con las herramientas de IA generativa. A partir de ellos adaptar los programas de RAI en consecuencia. A medida que las nuevas tecnologías de IA continúan surgiendo, es importante que los programas de RAI se mantengan actualizados.”

Ni de acuerdo ni en desacuerdo

“Lo que hemos visto últimamente es un rápido desarrollo tecnológico y la aparición de nuevas y potentes herramientas sin apenas debate público previo sobre los riesgos, las implicaciones sociales y los nuevos retos éticos que surgen. Todos tenemos que ir descubriéndolo sobre la marcha. En ese sentido, creo que la mayoría de los programas responsables de IA no están preparados”.

Linda Leopold

Grupo H&M

Nuestros expertos coinciden en gran medida en que los principios básicos de la RAI proporcionan una base para abordar los avances de la IA generativa.

Principios como la confianza, la transparencia y la gobernanza se aplican por igual a todas las herramientas de IA, sean generativas o no. En palabras de Ashley Casovan, directora ejecutiva del Responsible AI Institute:

“Se aplican las mismas reglas y principios básicos: Comprender el impacto o el daño de los sistemas que se pretende desplegar; identificar las medidas de mitigación adecuadas, como la aplicación de normas. Y establecer la gobernanza y la supervisión para controlar continuamente estos sistemas a lo largo de sus ciclos de vida“.

Por qué las empresas deben adoptar prácticas responsables con la Inteligencia Artificial

Del mismo modo, Steven Vosloo, especialista en política digital de la Oficina de Perspectiva y Política Mundial de UNICEF, observa:

“Los principios actuales de la IA responsable se aplican a las herramientas de IA generativa de nuevo desarrollo. Por ejemplo, sigue siendo necesario aspirar a que los sistemas de IA sean transparentes y explicables”.

Y Gandhi afirma:

“Los conceptos clave de la IA responsable pueden en realidad mitigar algunos de los riesgos de las nuevas herramientas de IA generativa”.

Las bases para abordar la IA generativa ya existen

Algunos expertos reconocen que las bases para abordar la IA generativa ya existen en organizaciones con sólidas prácticas de RAI.

Linda Leopold, responsable de IA y datos responsables del Grupo H&M, afirma:

“Si tienes una base sólida en tu programa de IA responsable, deberías estar algo preparado. Los mismos principios éticos seguirían siendo aplicables. aunque tengan que complementarse con orientaciones más detalladas. Si el programa de IA responsable ya tiene un fuerte enfoque en la cultura y la comunicación.”

David Hardoon, CEO de Aboitiz Data Innovation y jefe de datos y AI en Union Bank of the Philippines, también sostiene:

“La mayoría de los programas de RAI tienen los fundamentos necesarios que cubren la gama de riesgos de IA, generativos o no. Cualquier ‘falta de preparación’ surgiría de cómo estos programas de RAI se implementan, operacionalizan y hacen cumplir de manera integral.”

Por último, Simon Chesterman, decano y profesor de la Cátedra Provost de la Facultad de Derecho de la Universidad Nacional de Singapur, dice:

“Cualquier programa de RAI que sea incapaz de adaptarse a las tecnologías cambiantes no era adecuado para su propósito desde el principio. La ética y las leyes que sustentan la IA responsable deben estar preparadas para el futuro. Ser capaces de adaptarse a los cambios tecnológicos y a los casos de uso”.

Recomendaciones

Nuestras recomendaciones para las organizaciones que pretenden abordar los riesgos de las herramientas de IA generativa a través de sus esfuerzos de RAI son similares a las que se aplican para mitigar los riesgos de la IA de terceros. En concreto, recomendamos lo siguiente

Refuerza tus fundamentos de RAI y comprométete a evolucionar con el tiempo

Los conceptos, principios y postulados fundamentales de la RAI se aplican por igual a todas las herramientas de IA, sean generativas o no. Por lo tanto, el mejor punto de partida para abordar los riesgos de la IA generativa es asegurarse de que tu programa es sólido.

Para ello, madura tu programa de RAI tanto como sea posible para que cubra un ámbito amplio y sustantivo. Asegúrate de que se aplica en toda la organización y no de forma ad hoc. Además, dado el ritmo de avance tecnológico de la IA, comprométete con la RAI como un proyecto continuo y acepte que el trabajo nunca termina.

Inteligencia Artificial, ¿aliada para mejorar la aprobación de leyes?

Invierte en formación y concienciación adicionales

Además de contar con un sólido programa básico de RAI, las organizaciones deben invertir en educación y concienciación sobre la naturaleza y los riesgos de la IA generativa. Incluso a través de programas de formación para empleados. Dado que se trata de herramientas de uso general con una amplia gama de posibles casos de uso.

No pierdas de vista a tus proveedores

En este ecosistema de IA cada vez más complejo, las herramientas de terceros y las soluciones de proveedores, incluidas las basadas en IA generativa, introducen riesgos materiales para una organización. Para minimizar estos riesgos, incorpore prácticas sólidas de gestión de proveedores en el diseño y la implementación de su programa de RAI. Considera, por ejemplo, evaluaciones preliminares de riesgos, mediciones de sesgos y prácticas continuas de gestión de riesgos. No dé por sentado que puede externalizar la responsabilidad cuando algo vaya mal.

SOBRE LOS AUTORES

Elizabeth M. Renieris es editora invitada del programa Responsible AI Big Idea de la Sloan Management Review del MIT. David Kiron es coautor del libro Workforce Ecosystems: Reaching Strategic Goals With People, Partners, and Technology (MIT Press, 2023). Steven Mills es director gerente y socio de Boston Consulting Group (BCG), donde ejerce como jefe de ética de IA. Abhishek Gupta es el principal responsable y experto en IA de BCG.

Te recomendamosElizabeth M. Renieris, David Kiron, Steven Mills y Abhishek Gupta

Elizabeth M. Renieris es editora invitada del programa Responsible AI Big Idea de la Sloan Management Review del MIT, investigadora asociada en el Instituto de Ética en la IA de Oxford, investigadora asociada en el Centre for International Governance Innovation y autora de Beyond Data: Reclaiming Human Rights at the Dawn of the Metaverse (MIT Press, 2023). David Kiron es director editorial de MIT Sloan Management Review y coautor del libro Workforce Ecosystems: Reaching Strategic Goals With People, Partners, and Technology (MIT Press, 2023). Steven Mills es director gerente y socio de Boston Consulting Group (BCG), donde ejerce como jefe de ética de IA. Abhishek Gupta es el principal responsable y experto en IA de BCG, posee la beca del BCG Henderson Institute sobre inteligencia colectiva aumentada y es el fundador y principal investigador del Montreal AI Ethics Institute.y recibe contenido exclusivo