La iniciativa de IA responsable examina cómo las organizaciones abordan las prácticas de IA basándose en encuestas a ejecutivos de todo el mundo.

La iniciativa de IA responsable examina cómo las organizaciones definen y abordan las prácticas, políticas y normas de IA. Basándose en encuestas a ejecutivos de todo el mundo y en paneles de expertos más pequeños y seleccionados, el programa reúne perspectivas de diversos sectores y geografías con el objetivo de proporcionar información práctica sobre esta nueva pero importante área de interés para los líderes de la industria.

MIT Sloan Management Review y Boston Consulting Group han reunido un panel internacional de expertos en IA que incluye académicos y profesionales para ayudarnos a obtener información sobre cómo se está implementando la inteligencia artificial responsable (RAI) en las organizaciones de todo el mundo.

IA responsable y responsabilidad social corporativa: una mezcla difícil de conseguir

En nuestra encuesta global, el 70% de los encuestados reconoció haber tenido al menos un fallo en el sistema de IA hasta la fecha.

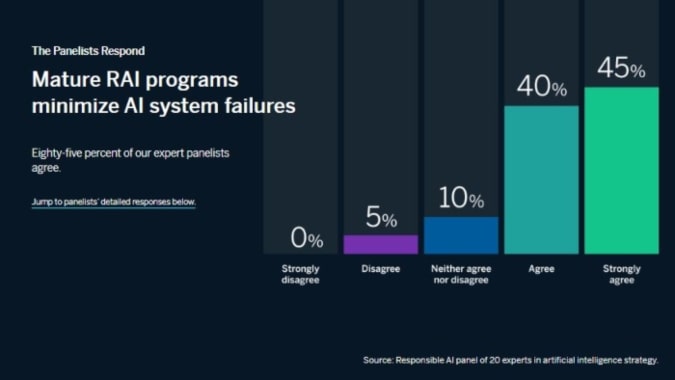

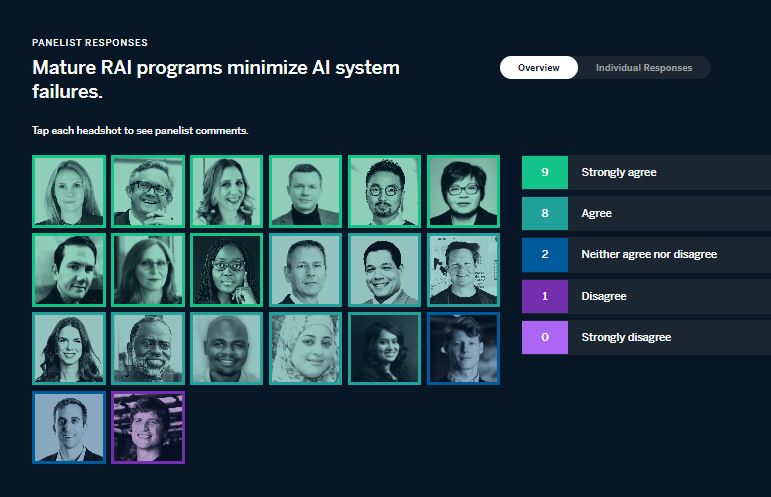

Este mes, pedimos a nuestros panelistas que reaccionaran al siguiente enunciado sobre el tema: Los programas maduros de RAI minimizan los fallos de los sistemas de IA.

Los encuestados apoyaron esta tesis de forma abrumadora, con un 85% (17 de 20) de acuerdo o muy de acuerdo con ella. Dicho esto, incluso entre los que están de acuerdo en que la RAI madura ayuda a minimizar los fallos del sistema de IA, advierten que no es por sí misma una bala de plata.

También influyen otros factores, como la definición de “fallo” y “RAI madura“, las normas de gobernanza y una serie de consideraciones tecnológicas, sociales y medioambientales.

A continuación, compartimos los puntos de vista de nuestros panelistas y nos basamos en nuestras propias observaciones y experiencia de trabajo en iniciativas de RAI para ofrecer recomendaciones a las organizaciones que buscan minimizar los fallos del sistema de IA a través de sus esfuerzos de RAI.

Poner en contexto la madurez y el fracaso

Para muchos expertos, la medida en que los programas RAI maduros pueden minimizar los fallos del sistema de IA depende de lo que entendamos por “programa RAI maduro” y “fallo“.

Algunos fallos son sencillos y fáciles de detectar. Por ejemplo, una de las categorías más visibles de fallos de la IA tiene que ver con la parcialidad.

Como observa Paula Goldman, jefa de ética y uso humano de Salesforce, “algunos de los mayores fracasos de la IA hasta la fecha han sido producto de la parcialidad, ya sean herramientas de contratación que favorecen a los hombres en detrimento de las mujeres o programas de reconocimiento facial que identifican erróneamente a las personas de color”.

Incorporar la ética y la inclusión en el diseño y la entrega de la IA no sólo ayuda a mitigar el sesgo, también ayuda a aumentar la precisión y la relevancia de nuestros modelos, y a aumentar su rendimiento en todo tipo de situaciones una vez desplegados”.

Los programas maduros de RAI están diseñados para anticiparse, detectar y rectificar el sesgo y otros desafíos visibles con los sistemas de IA.

Muy de acuerdo

“Los sistemas de IA pueden fracasar o tener éxito, y cualquier sistema de IA que tenga éxito debe ser éticamente responsable. Hay que rechazar la idea de que la ingeniería y la ética pueden separarse en ciertos aspectos. Decir: ‘Este sistema tiene éxito en sí mismo, pero sólo falla éticamente’, es una contradicción en los términos. Es similar a decir: ‘Es una gran persona pero sólo perjudica a los demás’. Si un sistema de IA tiene realmente éxito, debe ser éticamente maduro. Por lo tanto, si no es éticamente maduro, no es una IA exitosa”.

Tae Wan Kim

Escuela de Negocios Tepper, Carnegie Mellon

Pero a medida que los sistemas de IA se hacen más complejos, los fallos pueden ser más difíciles de detectar y de solucionar.

Como explica Nitzan Mekel-Bobrov, director de IA de eBay, “los sistemas de IA suelen ser el producto de muchos componentes, entradas y salidas diferentes, lo que da lugar a una fragmentación de la toma de decisiones entre los agentes. Por eso, cuando se producen fallos, es difícil determinar la razón precisa y el punto de fallo. Un marco maduro de IA responsable tiene en cuenta estos retos incorporando al ciclo de vida del desarrollo del sistema el seguimiento y la medición de extremo a extremo, la gobernanza sobre el papel desempeñado por cada componente y la integración en el resultado final de la decisión, y proporciona las capacidades necesarias para prevenir los fallos del sistema de IA antes de la toma de decisiones de la tecnología.”

Inteligencia Artificial en Qatar 2022: Detectar fuera de lugar, balón inteligente y más

Para hacer frente a fallos más y menos visibles, un programa de IA responsable maduro debe ser amplio en escala y/o alcance, abordando todo el ciclo de vida de un sistema de IA y su potencial de resultados negativos.

Como afirma Linda Leopold, jefa de IA y datos responsables en H&M, “Para que un programa de IA responsable se considere maduro, debe ser exhaustivo y ampliamente adoptado en toda la organización. Tiene que abarcar varias dimensiones de la responsabilidad, como la equidad, la transparencia, la responsabilidad, la seguridad, la privacidad, la solidez y la agencia humana. Y tiene que aplicarse tanto a nivel estratégico (político) como operativo”. Y añade: “Si cumple todas estas condiciones, debería evitar una amplia gama de posibles fallos del sistema de IA”.

Del mismo modo, David Hardoon, director de datos e IA de UnionBank of the Philippines, explica: “Un programa de RAI maduro debería cubrir la amplitud de la IA en términos de datos y modelos tanto para el desarrollo como para la operacionalización, minimizando así los posibles fallos del sistema de IA”.

De hecho, los programas de RAI más maduros están arraigados en la cultura de una organización, lo que conduce a mejores resultados.

Como explica Slawek Kierner, vicepresidente senior de datos, plataformas y aprendizaje automático de Intuitive, “los programas maduros de IA responsable trabajan a muchos niveles para aumentar la solidez de las soluciones resultantes que incluyen componentes de IA. Esto comienza con la influencia que la IA tiene en la cultura de los equipos de ciencia de datos e ingeniería, proporciona una supervisión ejecutiva y una clara rendición de cuentas para cada paso del proceso, y en el aspecto técnico garantiza que los algoritmos, así como los datos utilizados para el entrenamiento y las predicciones, sean auditados y monitoreados para detectar desviaciones o comportamientos anormales. Todos estos pasos aumentan en gran medida la solidez de todo el proceso de AI DevOps y minimizan los riesgos de fallos del sistema de IA.”

El papel de las normas emergentes

Algunos expertos advierten que, sin normas formales o ampliamente adoptadas sobre la IA, es más difícil establecer el impacto de los programas maduros de IA sobre los fallos del sistema de IA.

La directora ejecutiva del Responsible AI Institute, Ashley Casovan, sostiene que “a falta de una definición o un marco estándar adoptado a nivel mundial sobre lo que implica la IA responsable, la respuesta debería ser realmente “depende””.

Según Oarabile Mudongo, investigador del Center for AI and Digital Policy de Johannesburgo, esas normas están en camino: “Las empresas se están implicando más en la elaboración de la legislación relacionada con la IA y se están comprometiendo con los reguladores a nivel nacional. Los reguladores también están tomando nota, presionando para que los marcos reguladores de la IA incluyan mayores salvaguardas de datos, gobernanza y mecanismos de responsabilidad. Los programas de RAI maduros y los reglamentos basados en estas normas no sólo garantizarán el uso seguro, resistente y ético de la IA, sino que también ayudarán a minimizar los fallos del sistema de IA.”

Philip Dawson, jefe de política de Armilla AI, advierte que un enfoque superficial de las pruebas de IA en toda la industria también ha significado que la mayoría de los proyectos de IA fracasen en el desarrollo o corran el riesgo de contribuir a los daños en el mundo real después de su lanzamiento.

“Para reducir los fracasos“, señala, “los programas maduros de RAI deben adoptar un enfoque integral para las pruebas y la validación de la IA”.

Jaya Kolhatkar, director de datos de Hulu, está de acuerdo en que “para ejecutar un programa de RAI correctamente, debe haber un mecanismo que detecte los fallos más rápidamente y un sólido programa de garantía de calidad para minimizar los problemas generales.”

En resumen, los estándares para las pruebas de IA y la garantía de calidad ayudarían a las organizaciones a evaluar hasta qué punto los programas de RAI minimizan los fallos del sistema de IA.

El arte, la ley y la inteligencia artificial

Reconocer las limitaciones de la madurez

Incluso con los programas de RAI más maduros, pueden producirse fallos.

Como explica Aisha Naseer, directora de investigación de Huawei Technologies (Reino Unido), “el nivel de madurez de los programas de RAI desempeña un papel crucial a la hora de contemplar los fallos del sistema de IA; sin embargo, no hay garantía de que no se produzcan tales calamidades. Esto se debe a las múltiples causas potenciales de los fallos de los sistemas de IA, incluidas las limitaciones del entorno y los factores contextuales.”

Asimismo, el vicepresidente e ingeniero jefe de sostenibilidad y movilidad futura de Boeing, Brian Yutko, señala que “los programas de IA pueden eliminar algunos tipos de comportamientos no deseados de ciertos modelos aprendidos, pero el éxito o el fracaso general en la automatización de una función dentro de un sistema vendrá determinado por otros factores.”

Steven Vosloo, especialista en política digital de la Oficina de Perspectiva y Política Global de el Fondo de las Naciones Unidas para la Infancia (Unicef), argumenta de forma similar que los programas de RAI pueden reducir, pero no minimizar, los fallos del sistema de IA:

“Incluso si se desarrollan de forma responsable y para no hacer daño, los sistemas de IA pueden fallar. Esto puede deberse a limitaciones en los modelos algorítmicos, a objetivos del sistema mal planteados o a problemas de integración con otros sistemas”. En otras palabras, la RAI es sólo uno de los varios factores potenciales que afectan al funcionamiento, y a veces al fracaso, de los sistemas de IA en el mundo real.

De acuerdo

“Los programas de IA responsables consideran de antemano los posibles efectos secundarios negativos del uso de la IA al “obligar” a los equipos a pensar en cuestiones generales relevantes. Esto facilita la consideración y detección de fallos del sistema de IA que nuestras sociedades quieren evitar. Sin embargo, la detección de estos fallos potenciales por sí sola no los evita necesariamente, ya que requiere una actuación adecuada de la organización. Las organizaciones que tienen programas maduros de RAI probablemente actúen de forma adecuada, pero no es una garantía, especialmente cuando el “fallo” es beneficioso para el modelo de negocio.”

Richard Benjamín

Telefónica

Recomendaciones

Un programa maduro de RAI contribuye en gran medida a minimizar o, al menos, a reducir los fallos de los sistemas de IA, ya que un programa maduro de RAI es de amplia escala y/o alcance y aborda todo el ciclo de vida de un sistema de IA, incluyendo su diseño y, fundamentalmente, su despliegue en el mundo real.

Sin embargo, la ausencia de normas formales o ampliamente adoptadas de RAI puede dificultar la evaluación del grado en que un programa de RAI mitiga dichos fallos.

En particular, se necesitan mejores marcos de pruebas y de garantía de calidad. Pero incluso con el programa de RAI más maduro, pueden producirse fallos en el sistema de IA.

En resumen, las organizaciones que esperan que sus esfuerzos de RAI ayuden a reducir o minimizar los fallos del sistema de IA deben centrarse en lo siguiente:

1. Asegurar la madurez de su programa de RAI

La RAI madura es amplia en escala y/o alcance, abordando una amplia gama de áreas sustantivas y abarcando amplias franjas de la organización. Cuanto más maduro sea su programa, más probable será que sus esfuerzos eviten posibles fallos y mitiguen los efectos de los que se produzcan.

2. Adopte las normas

La estandarización de la RAI, ya sea a través de la nueva legislación o de los códigos del sector, es algo positivo. Adopte estas normas, incluidas las relativas a las pruebas y la garantía de calidad, como forma de garantizar que sus esfuerzos contribuyen a minimizar los fallos del sistema de IA.

3. Dejar de lado la perfección

Incluso con el programa de RAI más maduro, pueden producirse fallos en el sistema de IA debido a otros factores. No pasa nada. El objetivo es minimizar los fallos del sistema de IA, no necesariamente eliminarlos. Convierte los fallos en oportunidades para aprender y crecer.

SOBRE EL PANEL

MIT Sloan Management Review y Boston Consulting Group han reunido a un grupo internacional de más de 20 profesionales de la industria, académicos, investigadores y responsables políticos para que compartan sus puntos de vista sobre cuestiones fundamentales relacionadas con la IA responsable. A lo largo de cinco meses, pediremos a los panelistas que respondan a una pregunta sobre la IA responsable y expliquen brevemente su respuesta. Los lectores pueden ver todas las respuestas de los panelistas y los comentarios en el panel que aparece al final de cada artículo y continuar el debate en AI for Leaders, una comunidad de LinkedIn diseñada para fomentar la conversación entre expertos y líderes tecnológicos con ideas afines.

SOBRE LOS AUTORES

Elizabeth M. Renieris es editora invitada del programa MIT Sloan Management Review Responsible AI Big Idea y es investigadora asociada en el Instituto de Ética en la IA de Oxford. David Kiron es director editorial de MIT Sloan Management Review. Steven Mills es director general, socio y jefe de ética de la IA en Boston Consulting Group.

Síguenos en Google Noticias para mantenerte informado

Te recomendamosElizabeth M. Renieris, David Kiron y Steven Mills

Elizabeth M. Renieris es editora invitada del programa MIT Sloan Management Review Responsible AI Big Idea y es investigadora asociada en el Instituto de Ética en la IA de Oxford. David Kiron es director editorial de MIT Sloan Management Review. Steven Mills es director general, socio y jefe de ética de la IA en Boston Consulting Group.y recibe contenido exclusivo