Un grupo de expertos opina sobre si los programas RAI son utilizados eficazmente para minimizar los daños que podría causar la IA a terceros.

Por segundo año consecutivo, MIT Sloan Management Review y Boston Consulting Group (BCG) han reunido a un panel internacional de expertos en inteligencia artificial (IA). Este incluye académicos y profesionales para que nos ayuden a conocer cómo se está implantando la IA responsable (RAI) en organizaciones de todo el mundo.

El año pasado publicamos el informe “Para ser un líder de IA responsable, céntrate en ser responsable“. Este año, estamos examinando hasta qué punto las organizaciones están abordando los riesgos derivados del uso de herramientas de IA desarrolladas interna y externamente.

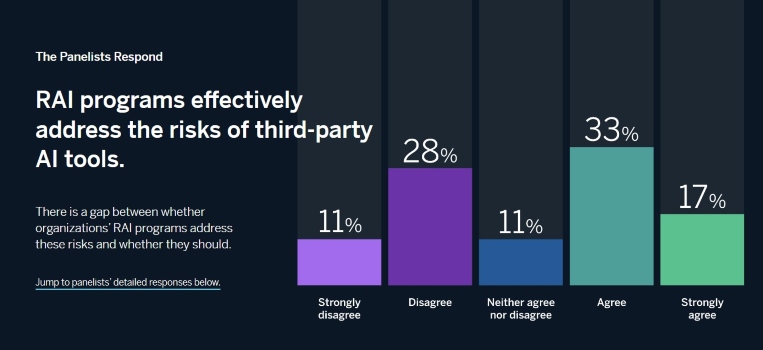

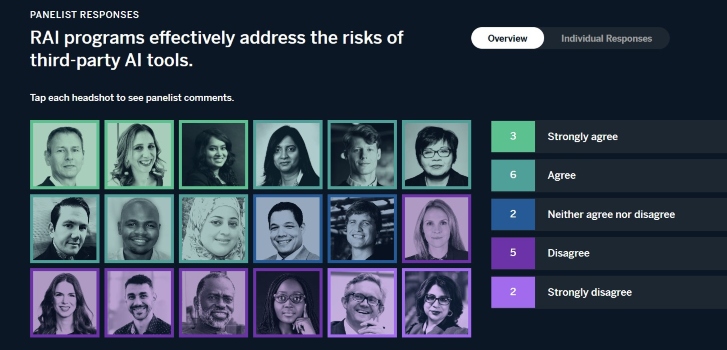

Para empezar, pedimos a nuestros panelistas que reaccionaran a lo que pensamos que sería una provocación directa: Los programas RAI abordan eficazmente los riesgos derivados del uso o la integración de herramientas de IA de terceros.

IA responsable y responsabilidad social corporativa: una mezcla difícil de conseguir

Aunque la mitad de nuestros panelistas están de acuerdo o muy de acuerdo con la afirmación, sus interpretaciones de la misma variaron ampliamente. Algunos panelistas se centraron en lo que las organizaciones hacen en la práctica, mientras que otros describieron lo que deberían hacer en principio.

En general, existe un amplio acuerdo en que los programas de RAI deben abordar los riesgos de dichas herramientas. Sin embargo, la medida en que realmente los abordan en la práctica es otra cuestión, en la que profundizaremos con nuestra investigación de este año.

A continuación, compartimos los puntos de vista de nuestros panelistas y nos basamos en nuestras propias observaciones y experiencia de trabajo en iniciativas de RAI. Esto con el objetivo de ofrecer recomendaciones sobre cómo las organizaciones podrían abordar los riesgos de las herramientas de IA.

Aumentan los riesgos de terceros

Nuestros expertos coinciden ampliamente en que los programas de RAI deben abordar los crecientes riesgos asociados al uso o la integración de herramientas de IA de terceros. Riyanka Roy Choudhury, becaria de Stanford CodeX, sostiene que se trata de un componente conceptual básico de un programa RAI eficaz.

“Uno de los principales principios y enfoques de los programas RAI es mitigar los riesgos de integrar herramientas de IA de terceros”, afirma.

Roboleyes: Principios de responsabilidad algorítmica en la Inteligencia Artificial

Para Nitzan Mekel-Bobrov, director de IA de eBay, también es una necesidad práctica.

“Las herramientas de IA de terceros, incluidos los modelos de código abierto, las plataformas de proveedores y las API comerciales, se han convertido en una parte esencial de la estrategia de IA de prácticamente todas las organizaciones, hasta el punto de que a menudo resulta difícil desligar los componentes internos de los externos”, explica.

“En consecuencia, un programa de IA necesita incluir políticas sobre el uso de herramientas de terceros, criterios de evaluación y las barreras necesarios”.

Y esa necesidad práctica es cada vez mayor. Por ejemplo, Richard Benjamins, estratega jefe de IA y datos de Telefónica, afirma:

“La IA como servicio es una tendencia, por lo que cada vez más organizaciones utilizarán herramientas de IA en la nube creadas por terceros.”

Citando la Ley de IA de la Unión Europea y otras normativas, sostiene que “por tanto, es de suma importancia que los programas de IA responsables tengan en cuenta toda la cadena de valor de la IA, además de los desarrollos de internos”.

¿Por qué la alta dirección debe empezar a preocuparse por la IA responsable?

Marcos normativos de IA, expectativas de los especialistas

A pesar del amplio acuerdo normativo de que los programas de IA deben abordar este tipo de riesgos, existe una falta de consenso sobre cómo deben hacerlo. Oarabile Mudongo, especialista en políticas del Observatorio Africano de la IA, afirma:

“Para abordar eficazmente los riesgos asociados a las herramientas de IA de terceros, los programas de RAI deben incluir un conjunto completo de políticas y procedimientos. Por ejemplo, directrices para el desarrollo ético de la IA, marcos de evaluación de riesgos y protocolos de supervisión y auditoría.”

Radhika Alla, vicepresidenta de plataformas digitales de la Clínica Mayo, afirma que “el mismo rigor de RAI utilizado para desarrollar modelos de IA internos debe aplicarse a la evaluación de plataformas y servicios de IA de terceros.”

Pero Belona Sonna, candidata al doctorado en el programa Humanising Machine Intelligence de la Universidad Nacional de Australia, no está de acuerdo. Sostiene que “los programas de RAI por sí solos no pueden abordar eficazmente los riesgos asociados al uso o la integración de herramientas de IA de terceros”.

En su lugar, recomienda implantar “un sistema de gestión de riesgos relacionado para herramientas de terceros que sirva para garantizar una perfecta cohesión entre las dos entidades de acuerdo con los principios RAI.”

La jefa de IA responsable de H&M, Linda Leopold, está de acuerdo en que la evaluación de los riesgos de las herramientas de IA de terceros.

“Requiere un conjunto de métodos diferente al de los sistemas de IA construidos internamente.”

¿Cómo controlar la IA? Los programas de Inteligencia Artificial Responsable son la solución

En desacuerdo, los programas RAI carecen de eficacia

“Los programas de IA responsable deben abarcar tanto las herramientas de IA construidas internamente como las de terceros. Deben aplicarse los mismos principios éticos, independientemente de la procedencia del sistema de IA. En última instancia, si algo saliera mal, no importaría a la persona afectada negativamente si la herramienta fue construida o comprada. Sin embargo, según mi experiencia, los programas de IA responsables tienden a centrarse principalmente en herramientas de IA desarrolladas por la propia organización.”

Linda Leopold

H&M

Los retos prácticos de la gestión de riesgos

El especialista en política digital del Fondo de las Naciones Unidas para la Infancia (Unicef), Steven Vosloo, afirma que el grado en que el programa de RAI de una organización aborda los riesgos de la IA de terceros en la práctica depende del rigor de su programa. Además, reconoce que “determinar cómo evaluar completamente los riesgos (reales o potenciales) de las herramientas de IA de terceros puede ser todo un reto”.

Para David R. Hardoon, director de datos e IA de UnionBank of the Philippines, el grado en que un programa de RAI aborda los riesgos de las herramientas de IA de terceros es una cuestión de lo exhaustivo que sea.

Como explica, “las consideraciones de un programa integral de IA responsable serían agnósticas con respecto a la plataforma utilizada para el desarrollo”, pero en la práctica los programas de RAI a menudo no logran “ampliar sus evaluaciones de riesgos relacionados con el sistema, y por lo tanto no necesariamente cubrirían los respectivos riesgos de integración que pueden existir cuando se trata de herramientas de IA de terceros.”

“Sigue existiendo una brecha importante en la fase de adquisición… donde muchas empresas simplemente no llevan a cabo evaluaciones personalizadas de las soluciones de IA de terceros. A medida que la innovación en IA se acelera, la necesidad de que los programas de RAI desarrollen sólidas políticas de adquisición de riesgos de terceros que incluyan evaluaciones de modelos de IA es más crítica que nunca.”

Philip Dawson

Armilla AI

Ignorar el poder de la IA, el verdadero riesgo latente

Simon Chesterman, director senior de gobernanza de IA en AI Singapore, afirma que uno de los mayores retos es “que no sabemos lo que no sabemos“. De hecho, la rápida adopción de la IA generativa está aumentando los riesgos que plantea la llamada IA en la sombra (usos que la organización desconoce por completo).

¿Qué es la inteligencia organoide y por qué amenaza a la IA?

Otro reto es la falta de normas del sector. Como explica la directora ejecutiva del Responsible AI Institute, Ashley Casovan.

“Debido a la falta de madurez en lo que significa la programación de la IA generativa, aún no existe una práctica recomendada para la integración de herramientas de terceros.”

Del mismo modo, Tshilidzi Marwala, rector de la Universidad de las Naciones Unidas, sostiene que certificar las herramientas de IA de terceros como responsables “requerirá unas normas mínimas que actualmente no existen”.

En consecuencia, las políticas de adquisición y post-adquisición son clave. Como señala Alka Patel, ex jefa de IA responsable del Departamento de Defensa de Estados Unidos.

“Una organización necesita incorporar mecanismos que le permitan seguir evaluando, actualizando e integrando la herramienta de IA de terceros después de la adquisición”.

Mantenerse alerta en medio del cambio

De hecho, la mitigación eficaz del riesgo requiere un enfoque continuo e iterativo de la RAI. Como explica Mudongo, “un enfoque proactivo para gestionar los riesgos de las herramientas de IA de terceros podría incluir una supervisión continua de las soluciones de IA“.

Cómo probar tecnología emergente sin morir en el intento

Del mismo modo, Alla afirma que “los programas y marcos de RAI necesitan supervisión y gobernanza continuas para garantizar que los principios clave de RAI sean aplicables”.

Giuseppe Manai, cofundador, director de operaciones y director de seguridad de datos de Stemly, está de acuerdo en que “los programas deben ser flexibles y dinámicos para seguir el ritmo de la evolución de las herramientas de IA.”

Paula Goldman, directora de ética y uso humano de Salesforce, sostiene:

“Esto es especialmente importante ahora, cuando las empresas se apresuran a anunciar nuevas asociaciones e invertir en startups para ayudarles a llevar la IA generativa al mercado.”

Recomendaciones

Para las organizaciones que buscan abordar los riesgos de las herramientas de IA de terceros a través de sus esfuerzos de RAI, recomendamos lo siguiente:

Minimizar la IA en la sombra

Es más fácil gestionar lo que se puede medir. Para mitigar eficazmente los riesgos de las herramientas de IA de terceros, las organizaciones necesitan una visión clara. Además de un inventario de los usos de la IA dentro de sus operaciones.

Asegúrate de que la mitigación de riesgos de terceros forma parte de su programa RAI

No basta con ser plenamente consciente de la IA. Para detectar y mitigar eficazmente los riesgos de terceros, su programa de RAI debe extenderse a todos los usos de la IA en la organización. Incluso a través de las políticas de adquisición y post-adquisición pertinentes.

Actualízate continuamente para abordar nuevos riesgos

Como ocurre con todos los demás componentes de la RAI, la mitigación de riesgos de terceros no es un ejercicio aislado. Ya sea debido a avances en IA o a desarrollos legales y normativos. Revisa regularmente su enfoque de la mitigación de riesgos de terceros en su programa RAI.

SOBRE EL PANEL

MIT Sloan Management Review y Boston Consulting Group han reunido a un grupo internacional de más de 20 profesionales para que compartan sus puntos de vista sobre la IA responsable. A lo largo de cinco meses, pediremos a los panelistas que respondan a una pregunta sobre la IA responsable y expliquen brevemente su respuesta. Los lectores pueden ver todas las respuestas de los panelistas en el panel que aparece al final de cada artículo. O continuar el debate en AI for Leaders, una comunidad de LinkedIn diseñada para fomentar la conversación entre expertos y líderes tecnológicos con ideas afines.

SOBRE LOS AUTORES

Elizabeth M. Renieris es editora invitada del programa Responsible AI Big Idea del MIT Sloan Management Review, investigadora asociada en el Instituto de Ética en la IA de Oxford, investigadora asociada en el Centro para la Innovación en la Gobernanza Internacional y autora de Beyond Data: Reclaiming Human Rights at the Dawn of the Metaverse (MIT Press, 2023). David Kiron es director editorial de MIT Sloan Management Review y coautor del libro Workforce Ecosystems: Reaching Strategic Goals With People, Partners, and Technology (MIT Press, 2023). Steven Mills es director gerente y socio de Boston Consulting Group (BCG), donde ejerce como jefe de ética de IA. Abhishek Gupta es el principal responsable y experto en IA de BCG, posee la beca del BCG Henderson Institute sobre inteligencia colectiva aumentada y es el fundador y principal investigador del Montreal AI Ethics Institute.

Te recomendamosElizabeth M. Renieris, David Kiron, Steven Mills y Abhishek Gupta

Elizabeth M. Renieris es editora invitada del programa Responsible AI Big Idea del MIT Sloan Management Review, investigadora asociada en el Instituto de Ética en la IA de Oxford, investigadora asociada en el Centro para la Innovación en la Gobernanza Internacional y autora de Beyond Data: Reclaiming Human Rights at the Dawn of the Metaverse (MIT Press, 2023). David Kiron es director editorial de MIT Sloan Management Review y coautor del libro Workforce Ecosystems: Reaching Strategic Goals With People, Partners, and Technology (MIT Press, 2023). Steven Mills es director gerente y socio de Boston Consulting Group (BCG), donde ejerce como jefe de ética de IA. Abhishek Gupta es el principal responsable y experto en IA de BCG, posee la beca del BCG Henderson Institute sobre inteligencia colectiva aumentada y es el fundador y principal investigador del Montreal AI Ethics Institute.y recibe contenido exclusivo