Un panel de expertos analiza si las organizaciones están ajustando eficazmente sus prácticas de gestión de riesgos para gobernar la Inteligencia Artificial (IA).

Por tercer año consecutivo, MIT Sloan Management Review y Boston Consulting Group (BCG) han reunido un panel internacional de expertos que incluye académicos y profesionales para ayudarnos a obtener información sobre cómo se está implementando la Inteligencia Artificial (IA) Responsable en las organizaciones de todo el mundo.

Este año, seguimos examinando la capacidad organizacional para abordar los riesgos relacionados con la IA. Pero en un panorama que incluye la primera ley integral de Inteligencia Artificial en los libros. La Ley de IA de la Unión Europea.

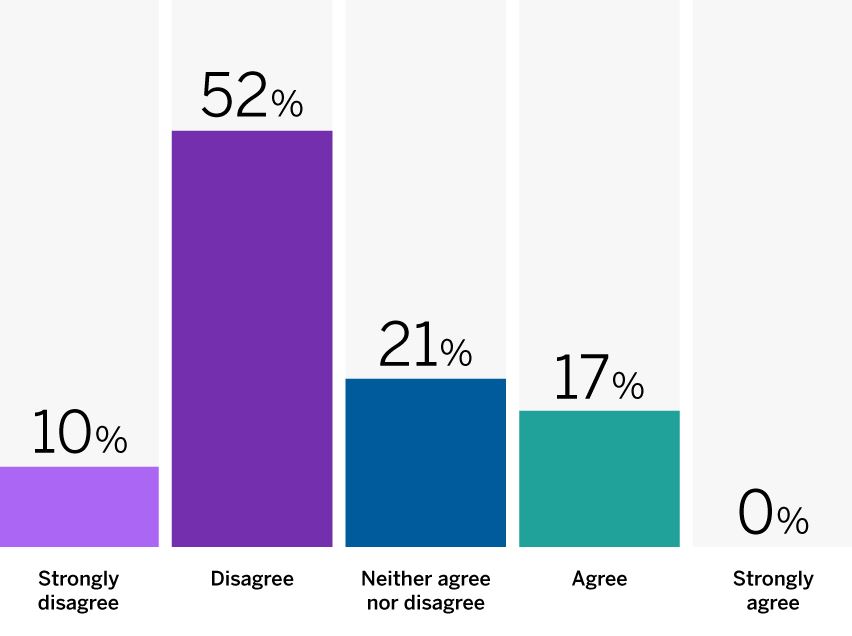

Para comenzar, les pedimos a nuestros expertos y a un gran modelo lingüístico que reaccionaran a la siguiente provocación: Las organizaciones están expandiendo lo suficiente las capacidades de gestión de riesgos para abordar los riesgos relacionados con la IA.

El 62 por ciento de nuestros panelistas no estuvo de acuerdo o estuvo muy en desacuerdo con la declaración. Citaron la velocidad del desarrollo tecnológico, la naturaleza ambigua de los riesgos y los límites de la regulación como obstáculos para una gestión de riesgos eficaz.

A continuación, compartimos las ideas de nuestros panelistas y nos basamos en nuestras propias observaciones y experiencias trabajando en iniciativas de Inteligencia Artificial Responsable (RAI).

Esto para ofrecer recomendaciones sobre cómo las organizaciones pueden aprovechar las capacidades de gestión de riesgos organizacionales para abordar los riesgos relacionados con la IA.

Más de la mitad de nuestros panelistas creen que las organizaciones no están ampliando suficientemente sus capacidades de gestión de riesgos para abordar los riesgos relacionados con la IA.

¿Cómo controlar la IA? Los programas de Inteligencia Artificial Responsable son la solución

Los avances tecnológicos están superando las capacidades de gestión de riesgos

Muchos de nuestros expertos citaron la velocidad de los desarrollos tecnológicos relacionados con la IA. Esto como una prueba de los límites de los marcos de gestión de riesgos organizacionales.

Como sostuvo Riyanka Roy Choudhury, becaria de Stanford CodeX, “la rápida expansión de la tecnología, en particular la IA generativa, ha superado las capacidades operativas de la mayoría de las organizaciones”.

Teddy Bekele, director de tecnología de Land O’Lakes, dijo que “la preparación general para abordar los riesgos relacionados con la IA es insuficiente, principalmente debido a los rápidos avances en tecnología que superan el desarrollo y la implementación de prácticas eficaces de gestión de riesgos”.

Además de las capacidades de rápida evolución de la IA, su ritmo de adopción también supone un desafío para las organizaciones. Como explicó Belona Sonna de AfroLeadership, “los sistemas tecnológicos se encuentran entre las aplicaciones de más rápido crecimiento en el mundo. Por tanto, los riesgos asociados son igualmente dinámicos”.

La ambigüedad es un desafío importante en temas IA

La ambigüedad sobre la naturaleza de los riesgos relacionados con la IA está poniendo a prueba los límites de las capacidades de gestión de riesgos existentes. especialmente en ausencia de estándares claros y establecidos para identificar, comprender y medir estos riesgos.

Mientras que algunas organizaciones están adaptando las capacidades de gestión de riesgos existentes, otras están intentando crear nuevas capacidades específicas para la tecnología.

Ranjeet Banerjee, CEO de Cold Chain Technologies, observó:

“No creo que hoy en día haya una buena comprensión de los riesgos relacionados con la IA en la mayoría de las organizaciones”.

Para algunas empresas, otro desafío es la falta de marcos claros y consistentes para la gestión de riesgos de la IA.

Franziska Weindauer, directora ejecutiva de TÜV AI.Lab, señaló la “falta de marcos y directrices desarrollados por actores expertos para ayudar a la gestión de riesgos”.

De manera similar, para el fundador de ForHumanity, Ryan Carrier, el “no incluir aportes diversos y comentarios de múltiples partes interesadas en el proceso de gestión de riesgos resulta en perspectivas limitadas sobre la identificación de riesgos y en la falta de divulgación de riesgos residuales”.

El papel de la regulación aún está por verse

Nuestros expertos están divididos sobre el papel de las regulaciones de IA. Rainer Hoffman, director de datos de EnBW, observó:

“Con la introducción de la Ley Europea de IA, que obliga a la gestión de riesgos para aplicaciones de alto riesgo, las organizaciones están empezando a reconocer la importancia de las consideraciones de riesgo relacionadas con la tecnología”.

Teemu Roos, profesor de la Universidad de Helsinki, añadió:

“Las empresas tendrán que invertir en el cumplimiento de la Ley de IA, de forma similar a la introducción del RGPD en 2018”.

Otros son menos optimistas sobre la eficacia de las regulaciones. El subsecretario general de la ONU, Tshilidzi Marwala, sostuvo que la maximización de las ganancias a través de la IA tiene más incentivos que la atención a los riesgos relacionados con la tecnología.

La inteligencia artificial responsable permite el tipo de innovación que importa

Recomendaciones para utilizar la IA de forma amigable

Para las organizaciones que buscan aprovechar su capacidad de gestión de riesgos organizacionales para abordar los riesgos relacionados con tecnología, recomendamos lo siguiente:

1. Identificar primero los principios básicos

Dado que los riesgos de la IA son dinámicos y evolucionan rápidamente, las organizaciones deben adoptar un enfoque ágil. Este debes estar basado en principios rectores y medidas de protección de alto nivel.

2. Mantenerse ágil y seguir aprendiendo

Las organizaciones deben reconocer que el aprendizaje colectivo sobre los riesgos de la IA y los enfoques de mitigación es continuo. Sus propios enfoques deberán evolucionar rápidamente junto con la creciente comprensión de todos.

3. Aumentar las inversiones en herramientas de mitigación de riesgos

Las organizaciones deben tratar de identificar dónde las herramientas actuales de mitigación de riesgos podrían abordar los riesgos relacionados con la IA.

Se podría invertir en capacidades de gestión de riesgos ampliadas donde las funciones existentes sean insuficientes. Dado que los riesgos de la IA pueden surgir tanto dentro como fuera de la organización, los enfoques de mitigación de riesgos deben diseñarse para abordar ambos tipos de riesgos.

4. Actuar ahora

Aunque la Ley de IA de la UE puede ser la única ley integral sobre IA en la actualidad, podemos apostar a que no será la única. Además, no hay ninguna exención de IA en las leyes vigentes.

Dado que puede llevar varios años implementar un programa integral de gestión de riesgos de IA. Las organizaciones no pueden esperar a que las regulaciones desarrollen un enfoque deliberado y flexible para la gestión de riesgos.

ACERCA DEL PANEL

MIT Sloan Management Review y Boston Consulting Group reunieron a un panel internacional de más de 20 profesionales de la industria. Esto para compartir sus puntos de vista sobre cuestiones fundamentales relacionadas con la IA responsable.

SOBRE LOS AUTORES

Elizabeth M. Renieris es editora invitada del programa Big Idea de IA Responsable de MIT Sloan Management Review. Steven Mills es director ejecutivo y socio de Boston Consulting Group, donde se desempeña como director de ética en IA.

Te recomendamosElizabeth M. Renieris, David Kiron y Steven Mills

Elizabeth M. Renieris es editora invitada del programa Big Idea de IA Responsable de MIT Sloan Management Review , investigadora asociada sénior en el Instituto de Ética en IA de Oxford, investigadora sénior en el Centro de Innovación en Gobernanza Internacional y autora de Beyond Data: Reclaiming Human Rights at the Dawn of the Metaverse (MIT Press, 2023). Obtenga más información sobre su trabajo aquí . David Kiron es director editorial de MIT Sloan Management Review y coautor del libro Workforce Ecosystems: Reaching Strategic Goals With People, Partners, and Technology (MIT Press, 2023). Steven Mills es director ejecutivo y socio de Boston Consulting Group, donde se desempeña como director de ética en IA.y recibe contenido exclusivo