IA y Recursos Humanos: Si rechazas candidatos, diles por qué

Los candidatos que no pasan un proceso de selección, merecen tener un feedback. (MIT SMR)

Los candidatos que no pasan un proceso de selección, merecen tener un feedback. (MIT SMR)

Tanto la Inteligencia Artificial explicable como el juicio humano ético desempeñan un papel importante en la evaluación justa y precisa del talento.

Los seres humanos estamos diseñados para crear significados, continuamente buscamos patrones y contamos historias para encontrar un sentido a los acontecimientos de la vida. Este intenso deseo de comprender el mundo va de la mano del auge de la Inteligencia Artificial (IA) en el mundo empresarial.

Esperamos que esta herramienta contribuya a encontrar nuevos significados, no sólo para predecir que X lleva a Y en el trabajo. Sino también para explicarnos por qué sucede así. Es decir, esperamos que la IA sea explicable.

Las definiciones varían, pero en un reciente artículo, mis colegas y yo definimos la IA explicable como “la cualidad de un sistema de proporcionar decisiones o sugerencias que puedan ser entendidas tanto por usuarios como por desarrolladores”.

Se trata de una cualidad muy útil para las aplicaciones diseñadas para evaluar personas.

La IA se volverá el Tinder de los Recursos Humanos en los próximos dos años

Evaluar, un acto que va más allá de calificar algo como ‘bueno’ o ‘malo’

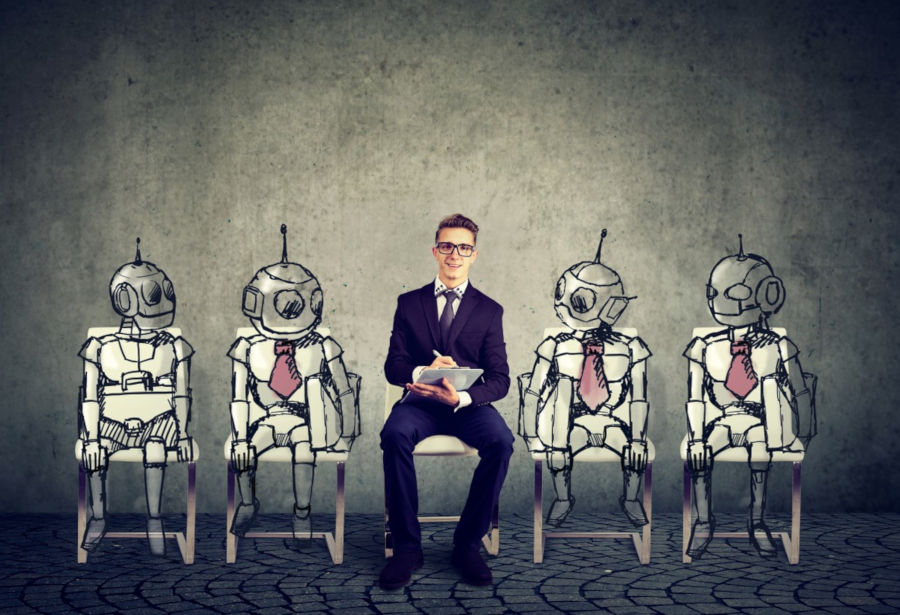

Por ejemplo, la mayoría de los gerentes de contratación no se conforman con saber que un algoritmo seleccionó a una persona o que a alguien “le fue bien” en una entrevista en la que se utilizó IA como motor de puntuación.

También quieren saber cómo es que las personas tuvieron un buen desempeño: ¿Hicieron más contacto visual que los demás? ¿Estaban menos nerviosos? ¿Utilizaron más palabras de impacto emocional?

Por supuesto, los candidatos también quieren saber esas cosas. De lo contrario, los resultados parecen arbitrarios y uno no puede aprender ni mejorar para su próxima vacante o entrevista.

Teoría + práctica

En los albores de la revolución de la IA, las empresas estaban entusiasmadas con esta nueva ventana al comportamiento del personal. Si alguien, por ejemplo, iba al baño más de tres veces al día, se consideraba que tenían un X por ciento más de probabilidades de abandonar su trabajo.

Pero tales datos sobre el comportamiento humano resultan inútiles, a menos de que podamos calificarlos o dotarlos de sentido:

- Iban al baño 3 o más veces, porque estaban: a) estresados, b) aburridos o c) querían consumir drogas.

Por supuesto, las explicaciones son hipotéticas, pero tener algunos supuestos es mejor que nada. Los científicos han estado de acuerdo con esta forma de pensamiento desde hace siglos. Para pasar de los datos al conocimiento, se necesita un contexto o, mejor aún, un modelo.

La ciencia sólo es una combinación de datos más teoría y esto es tan cierto cuando evaluamos personas como cuando evaluamos ideas. El por qué importa.

Recursos humanos y TI: Forjar alianzas para impulsar la transformación digital

Herramientas transparentes, así es como la IA ayuda a RH

La IA explicable suena como un concepto nuevo, pero en esencia ha existido desde hace décadas. En Estados Unidos, la calificación crediticia tiene un “derecho a explicación” bien establecido. Esto a través de la Ley de Igualdad de Oportunidades Crediticias, promulgada en 1974.

Ahora, en lugar de personas, son los algoritmos los que determinan si su calificación crediticia es alta o baja. Pero usted debería poder averigua por qué.

¿Es baja porque olvidó pagar algunas cuotas y se retrasó en el pago? O quizá es porque se ajusta a un determinado perfil demográfico que está asociado con un mayor riesgo.

Las agencias de crédito cumplen con esta regulación y ofrecen una lista de explicaciones para que pueda entender qué ocurrió y cómo mejorar su puntaje. Esta transparencia beneficia tanto a los prestatarios como a los prestamistas.

Del mismo modo, en el ámbito de las contrataciones y los recursos humanos, los empleadores éticos deben a los candidatos y empleados un derecho similar. Nunca ha sido fácil decirle a la gente por qué no consiguieron un trabajo o un ascenso.

Es por eso que tantas organizaciones envían cartas de rechazo genéricas, en donde sólo indican que había muchos candidatos calificados. Es el equivalente laboral al típico “no eres tú, soy yo” de las parejas que quieren romper.

Pero en la medida en que la IA pueda revelar razones específicas para no seleccionar a ciertos candidatos, esta información debe compartirse con ellos y, de hecho, puede ayudarles a procesar la noticia.

¿Qué aspectos trae consigo la nueva transparencia impulsada por la IA?

Por ejemplo, si una herramienta de barrido de currículos no preselecciona a un candidato, sería positivo para él o ella si supiera que no fue elegido/a porque no enlistó ciertas habilidades específicas.

Así, ellos pueden revisar su CV y resaltar o conseguir aquellas cualidades necesarias para aumentar sus posibilidades de contratación.

Si un sistema automatizado que analiza videoentrevistas determina que a alguien le falta la calidez o la confianza para tener un puesto de ventas, esa retroalimentación podría ayudar al candidato a prepararse para su próxima entrevista. Podría practicar hacer más contacto visual, hablar más, hacer menos pausas.

O, si los algoritmos de procesamiento del lenguaje natural detectaron evidencia de un “lado oscuro” o tendencias tóxicas en el comportamiento de alguien en las redes sociales, tal vez esto debería hacerse notar, no sólo para el reclutador sino también para el candidato, así sería más consciente y ajustaría su comportamiento y mantendría bajo control sus prácticas poco deseables.

10 lecturas obligadas para entender la Inteligencia Artificial

Aspectos clave de la tensión ética

Sin duda, siempre habrá controversias por las decisiones y juicios que se hagan en torno al posible desempeño de las personas. Pero no utilizar la IA no impedirá que alguien tome la decisión de no contratar o ascender a alguien. Y los humanos son mucho más parciales que los sistemas automatizados.

Los gerentes que se preocupan por los modelos “caja negra” deberían preocuparse también por la poca transparencia en el historial laboral de los candidatos.

Nunca podemos estar seguros de por qué alguien seleccionó o rechazó a una persona si la decisión fue puramente humana. Todo lo que podemos hacer es confiar en la explicación sesgada de quien tiene la última palabra.

Si bien las herramientas de IA no están libres de sesgos, pueden ayudar a mitigarlos y los empleadores pueden mejorar la precisión y la equidad de las decisiones. Además, pueden elevar los estándares éticos para diseñar algoritmos y compartir resultados.

IA y manipulación genética, ¿por qué las industrias se benefician de ambos?

La IA no es la mejor herramienta en RH

El hecho de que la IA sea explicable no la convierte en una herramienta perfecta. Esto es porque puede fomentar decisiones poco éticas si no se usa con un buen juicio basado en principios.

Imagine, por ejemplo, una herramienta que ayude a los gerentes a evaluar a las personas en función de su ideología política, creencias religiosas o la clase social a la que pertenezcan.

Por muy transparentes que sean los criterios de selección, la herramienta no será justa. Es más, casi cualquier rasgo psicológico que explique estos comportamientos puede influir a la hora de determinar si es agradable trabajar con alguien o no.

Entonces, es irónico, pero cuando aumentamos las explicaciones, también, de alguna manera, hacemos que las personas puedan elegir más fácilmente con base en sus propios prejuicios y preferencias.

Aun así, a fin de cuentas, estamos mejor con las explicaciones que sin ellas. La auditoría de algoritmos, un proceso que detecta los sesgos integrados a un sistema, es un paso tecnológico hacia la ética explicable de la IA. Pero está lejos de ser imparcial: los sesgos suelen eludir su detección aun cuando se buscan activamente.

Conforme avanzamos en este frente, también debemos tener en cuenta el impacto de los algoritmos, preguntándonos continuamente sus efectos reales sobre las personas cuando se utilizan para evaluarlas, si reforzarán o debilitarán la equidad y cuáles podrían ser las consecuencias sociales más amplias de su uso.

Si todo el tiempo tratamos de responder ese tipo de preguntas, estaremos en una mejor posición para tomar decisiones menos sesgadas sobre las personas y podremos ayudarlas a comprender y desarrollar su propio potencial.

SOBRE EL AUTOR

Tomas Chamorro-Premuzic (@drtcp) es científico en jefe de talento para ManpowerGroup y profesor de psicología empresarial en el University College London. Es autor del libro Why Do So Many Incompetent Men Become Leaders? (and How to Fix It) (Harvard Business Review Press, 2019).