Monitoreo digital durante la crisis sanitaria

A medida que el mundo se recupera de la onda de choque inicial, causada por la pandemia de COVID-19, las empresas se están preparando para transformarse de regreso a sus lugares de trabajo físicos.

Para proteger la salud y el bienestar de los empleados, las organizaciones deben rediseñar sistemáticamente sus espacios laborales. Esto puede incluir reconfigurar oficinas, reorganizar escritorios, cambiar los turnos de las personas, para minimizar el hacinamiento y permitir que las personas trabajen de forma remota a largo plazo. Luego están las medidas puramente médicas, como controles periódicos de temperatura, la provisión de máscaras faciales y otros equipos de protección personal, e incluso médicos en el lugar. Tales precauciones habrían parecido extremas hace poco tiempo, pero se están convirtiendo rápidamente en prácticas aceptadas.

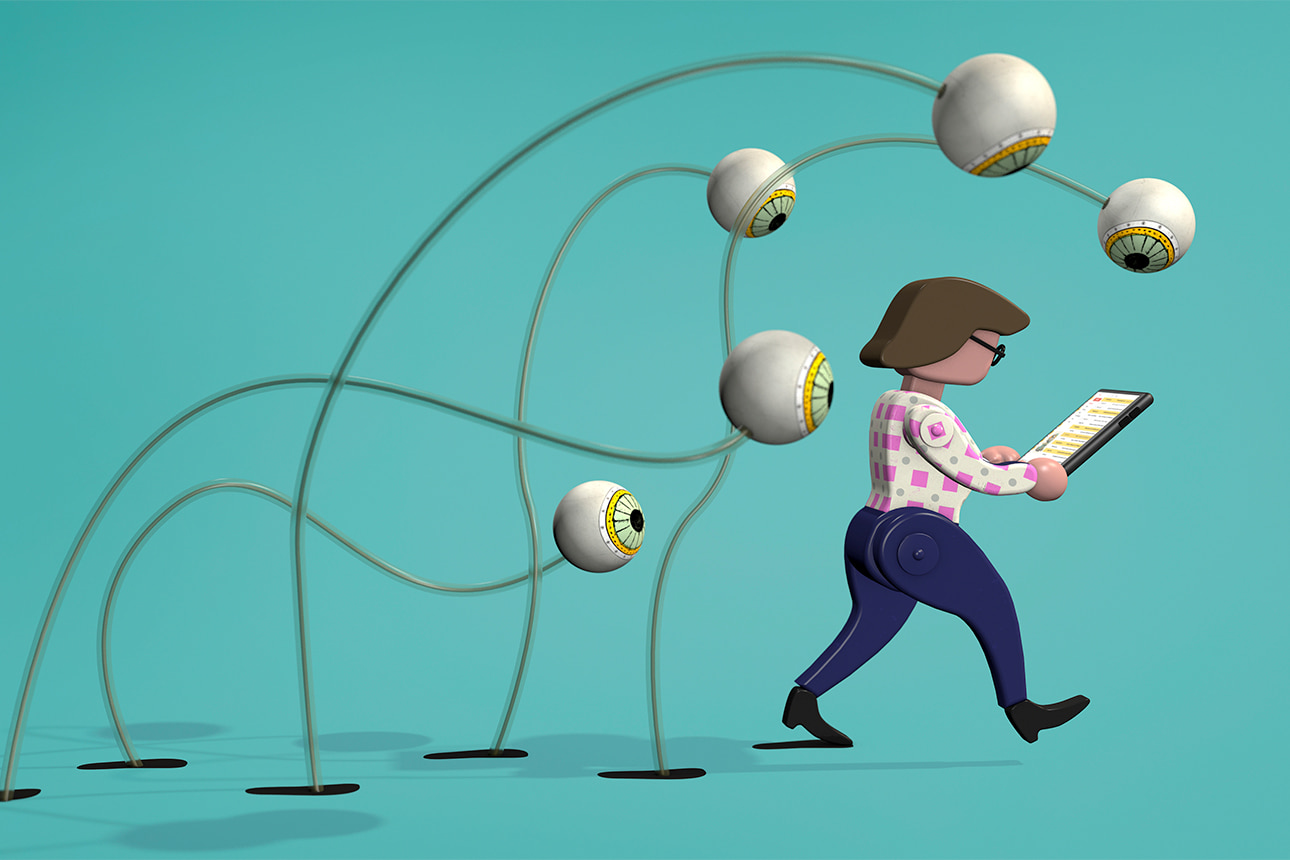

Pronto, las organizaciones también pueden comenzar a monitorear el paradero y el comportamiento de los empleados más de cerca que nunca, utilizando herramientas de vigilancia como aplicaciones para teléfonos celulares, sensores de oficina, y algoritmos que raspan y analizan la gran cantidad de datos que las personas producen mientras trabajan. Incluso, cuando no están en la oficina, los trabajadores generan un mar de datos mediante sus interacciones en plataformas de correo electrónico, Slack, mensajes de texto e instantáneos, videoconferencias y la llamada telefónica aún no extinta.

Con la ayuda de Inteligencia Artificial (IA), estos datos pueden traducirse en diagnósticos automatizados en tiempo real que miden la salud y el bienestar de las personas, sus niveles de riesgo actuales y su probabilidad de riesgo futuro. Un paralelo aquí es el uso de varias medidas de vigilancia por parte de muchos gobiernos, con cierto éxito, para contener la pandemia (China, Israel, Singapur y Australia, por ejemplo). En particular, se han implementado herramientas de seguimiento y localización para seguir cada movimiento de las personas, con la intención de aislar a las personas infectadas y reducir el contagio.[i]

La vigilancia tecnológica siempre es controvertida, sobre todo porque no está sincronizada con los valores y principios básicos que sustentan las sociedades libres y democráticas. De hecho, la idea de usar IA para realizar tareas previamente “humanas” ya se considera muy polarizante; para muchos de nosotros, la noción de usarla también en el sistema de vigilancia agrega un escalofriante elemento orwelliano.

Sin embargo, en sociedades libres y democráticas, hemos regalado tantos datos personales en la era digital que el concepto de privacidad se ha devaluado y diluido en gran medida. Ocasionalmente lo hicimos con la esperanza de estar más seguros o ser más saludables, pero principalmente para consumir anuncios más relevantes, ver películas más interesantes, presumir del salón, del club ejecutivo y espiar a personas con las que salimos en la escuela secundaria (sí, somos aparentemente capaces de ser espeluznantes también).

Igualmente, antes de la pandemia, las empresas ya estaban implementando Inteligencia Artificial para administrar sus fuerzas laborales. Muchos empleadores lo usaban para medir el potencial de las personas o predecir sus talentos, gracias al floreciente campo de análisis de personas.[ii] De hecho, el aumento actual de los datos como moneda dominante en recursos humanos se remonta a los inicios del Movimiento de Gestión Científica hace más de 100 años, cuando Frederick Taylor fue pionero en los esfuerzos para convertir grandes organizaciones en laboratorios de recursos humanos, midiendo cada movimiento de los empleados.

Se podría argumentar que la IA ha promovido esa búsqueda continua para mejorar el rendimiento de la fuerza laboral, y usarla para mantener a los empleados seguros y saludables es otro paso que debe darse en esa dirección.

Las capacidades que existen

Modelar los estados de salud y los niveles de riesgo de los trabajadores y predecir si las personas son una amenaza para sus colegas implica un trabajo sofisticado. La mayoría de las organizaciones aún no cuentan con las herramientas y capacidades, y es difícil decir cuántas están avanzando, ya que son reacias a anunciar tales esfuerzos. Pero hay una gran cantidad de investigación académica que muestra el potencial para la aplicación en el mundo real, incluidos los estudios científicos que identifican varias señales digitales -el tipo de datos que producimos y enviamos- como indicadores de salud o marcadores de riesgo. Algunas compañías han conectado estos puntos en el mercado, como en los momentos en que Target pudo inferir que una de sus clientes adolescentes estaba embarazada, antes de que su padre lo supiera, al comparar sus hábitos de compra con los de otras clientas también encinta; y cuándo Google Flu Trends predijo las epidemias en toda la población al agregar búsquedas individuales

En la medida en que los empleadores puedan acceder de manera similar a los datos de comportamiento, pueden crear perfiles de salud y riesgo en la vida de sus trabajadores, con los cuales puedan intervenir para proteger su bienestar.

Considere el potencial para aprovechar el procesamiento del lenguaje natural, un subcampo de lingüística computacional que detecta las conexiones entre el uso del lenguaje por parte de los individuos (qué palabras usamos, con qué frecuencia y en qué contexto) y sus estados emocionales, psicológicos y de salud.[iii]

Debido a que la mayor parte de nuestra comunicación, a través de correos electrónicos, llamadas o videoconferencias ahora está grabada, los empleadores podrían implementar Inteligencia Artificial de manera factible para identificar marcadores de riesgo a nivel individual y grupal. Este enfoque fue implementado por universidades en Singapur, donde los videos de las clases presenciales revelaron interacciones entre estudiantes que ya estaban enfermos y otras situaciones.

Con tantas reuniones en línea, las compañías también pueden extraer comunicaciones de video para el lenguaje corporal o las expresiones faciales, con el fin de identificar cambios en los patrones y evaluar si las expresiones no verbales, incluidas las propiedades físicas del habla (tono, inflexión, tono, cadencia), pueden indicar riesgo.[iv]

El análisis de redes sociales ofrece oportunidades adicionales para la evaluación e intervención de riesgos. Los metadatos del e-mail (a quién envía, cuándo y con qué frecuencia) y los datos de seguimiento de los sensores, ubicados en las habitaciones o en las personas, como el experimento pionero desarrollado por Ben Waber del MIT y su compañía Humanyze, podrían usarse para controlar si las personas que han exhibido síntomas de COVID-19 o aquellas que hayan dado positivo en las pruebas, tuvieron contacto con colegas que, dependiendo las circunstancias, luego podrían ponerse en cuarentena.

Un poco más difícil, pero no imposible de imaginar, sería que los empleadores también quisieran acceder a datos de Uber, Waze, Google Maps, WhatsApp, WeChat u otras aplicaciones para verificar a dónde van las personas, con quién se conectan y qué dicen. Tales datos podrían, en teoría, usarse no sólo para diagnosticar a aquellos que no son conscientes de sus riesgos o enfermedades, sino también para detectar a quienes guarden secretos.

Las restricciones que necesitamos

Antes de la pandemia, había una brecha clara entre lo que las compañías podían saber y deberían saber sobre las personas. Y esa brecha crecerá en el futuro cercano. Es probable que las personas se sientan menos molestas por Google, Facebook y Amazon, que analizan cada uno de sus movimientos -y comercializan sus datos- que los empleadores que extraen sus datos de trabajo. Aunque los términos de los acuerdos con los proveedores de productos y servicios a menudo están enterrados en letra pequeña, los consumidores pueden optar por dar o negar su consentimiento.

Para estar seguros, se necesitan restricciones legales para evitar que cualquier persona tenga mayor conocimiento de lo que deberían saber sobre nosotros, y se interfiera con nuestras libertades y derechos.[v] Sin embargo, existen formas éticas de implementar nuevas tecnologías, incluida la Inteligencia Artificial de vigilancia para promover la seguridad en el trabajo.

Primero, las organizaciones deben asegurarse de que los empleados sepan muy claramente cuál es el trato: qué datos están recopilando y por qué. En segundo lugar, una vez que estén informados sobre el proceso y comprendan las razones que lo respaldan, deberían tener la posibilidad de optar por no participar sin temor a una sanción o, mejor aún, elegir de forma proactiva optar por participar porque ven el valor de hacerlo.

En tercer lugar, los propios empleados deberían beneficiarse al compartir sus datos y hacer que los algoritmos analicen su actividad, ya sea que estén obteniendo comentarios sobre el desarrollo, un aumento en la satisfacción laboral o compromiso, niveles más altos de desempeño laboral o productividad; o, ahora, durante la pandemia, una sensación de protección y una mayor probabilidad de mantenerse saludable.

En el momento de comprometerse con los empleados, de manera transparente y al compartir hallazgos de alto nivel con ellos -al tiempo que preservan el anonimato y la confidencialidad individuales-, las empresas pueden mostrar a las personas que vale la pena optar por ellas y, por lo tanto, atenuar el miedo de la IA.

Los líderes, por supuesto, deben conocer las limitaciones de la tecnología, dado que los falsos positivos y los falsos negativos son muy comunes. Este no es un problema trivial. Algunas de las aplicaciones más utilizadas de la Inteligencia Artificial, como el motor de recomendaciones de Amazon, sugieren que la precisión de las estimaciones académicas es de alrededor del 5% .[vi] Las compañías deben tenerlo en cuenta en su modelado; además, las señales pueden ser predictivas, pero difíciles de interpretar.

La mayoría de los empleadores carecen no sólo del volumen y la calidad de los datos que tienen las grandes empresas tecnológicas, sino también de los científicos expertos en datos para que tengan sentido. Esas organizaciones necesitarían el apoyo de expertos externos para convertir los datos en algoritmos automatizados que puedan mantener a las personas seguras.

Finalmente, los empleados deben confiar en sus líderes para desplegar nuevas tecnologías, para su bienestar, incluida la Inteligencia Artificial. Ganar esa confianza requiere una gran transparencia, explicando por qué y cómo se usa esta tecnología, cuáles son los factores clave que impulsan las recomendaciones del sistema, y cuáles son las limitaciones tecnológicas en las decisiones de juicio humano que alimentan el sistema e interpretan los datos.

Los empleados deben sentir que sus líderes están realmente interesados en aumentar su rendimiento, mejorar su salud y mantenerlos seguros, y que la IA de vigilancia hará de la empresa un mejor lugar para trabajar; incluso, los esfuerzos bien intencionados para aprovechar para proteger a las personas podrían ser contraproducentes si las empresas no tienen una cultura de confianza, y si los empleados desconfían de los líderes y ejecutivos que se encuentran en los niveles más altos de su compañía.

Versión al español: Armando Cintra Benítez

A partir de:

[i] S. Bond, “Apple and Google Build Smartphone Tool to Track COVID-19,” NPR, April 10, 2020, www.npr.org.

[ii] J. Bersin and T. Chamorro-Premuzic, “New Ways to Gauge Talent and Potential,” MIT Sloan Management Review 60, no. 2 (winter 2019): 7-10; and H. Schellmann, “How Job Interviews Will Transform in the Next Decade,” The Wall Street Journal, Jan. 7, 2020, www.wsj.com.

[iii] R.A. Calvo, D.N. Milne, M.S. Hussain, et al., “Natural Language Processing in Mental Health Applications Using Non-Clinical Texts,” Natural Language Engineering 23, no. 5 (September 2017): 649-685.

[iv] P. Wlodarczak, J. Soar, and M. Ally, “Multimedia Data Mining Using Deep Learning,” in “Fifth International Conference on Digital Information Processing and Communications” (Sierre, Switzerland: IEEE, 2015).

[v] B. Dattner, T. Chamorro-Premuzic, R. Buchband, et al., “The Legal and Ethical Implications of Using AI in Hiring,” Harvard Business Review, April 25, 2019, https://hbr.org.

[vi] A. Agrawal, J. Gans, and A. Goldfarb, “Prediction Machines: The Simple Economics of Artificial Intelligence” (Boston: Harvard Business Review Press, 2018).